Вы используете устаревший браузер. Этот и другие сайты могут отображаться в нем неправильно.

Необходимо обновить браузер или попробовать использовать другой.

Необходимо обновить браузер или попробовать использовать другой.

Улучшатель имиджей родился ли?

- Автор темы Evgen

- Дата начала

- Сообщения

- 13 904

- Реакции

- 4 297

ITIT

20 лет на форуме

- Сообщения

- 522

- Реакции

- 200

Текстом есть,но нужна регистрация,да и ссылки на данный ресурс отдельных товарищей

приводят в сильное нервное возбуждение.

Кому интересно, то

приводят в сильное нервное возбуждение.

Кому интересно, то

- Сообщения

- 34 418

- Реакции

- 11 271

Да там обычный ютюбовский обзор нескольких известных ресамплеров и нейросетей. Я по диагонали потыкал, по мне так результат достаточно бестолковый и капитанский, напоминает сравнительный анализ дошираков из пятерочки в утренних новостяхВидать шибко ценная информация, раз ее без регистрации не узнать.

mihas

15 лет на форуме

- Сообщения

- 4 860

- Реакции

- 2 898

Да примерно как раз 22 году адекватно, вот году в 25 - уверен - должны разрешение модели увеличить.По ходу в 2022 году — уже нет

Я просто исхожу из того, что сегодня мейнстрим - видюха с 2-8 гигами на борту, под такие видюхи и модель на 1024 пиксела. Через несколько лет когда станет мейнстримом 12-16 гигов видеопамяти и производительность повыше - будет и разрешение повыше у проектов.

Aлексей Иванов

Участник

- Сообщения

- 76

- Реакции

- 51

Компания Репропарк занимается созданием вебсервиса на ИИ по вытягиванию детализации при апсемплинге - для этикеточных картинок прям огонь как детализация вытаскивается. Можно попробовать на них выйти - технического директора Яков Сотников зовут. Может помогут - лица не очень получаются, а вот всякие фрукты вилки и прочая хрень прям реально суперски выходят.Приветствую, коллеги!

Можно ли подлечить пациентав аттачепо ссылке http://umbum.ru/ftp/2013.09.JPG

Хочется найти побольше качества в этом имидже.

Или услышать дельный совет по улучшению.

mihas

15 лет на форуме

- Сообщения

- 4 860

- Реакции

- 2 898

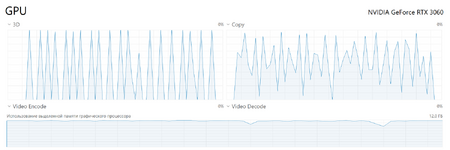

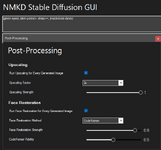

Попробовал проект с графическим интерфейсом NMKD Stable Diffusion GUI

Если немного поучиться и поосваивать - можно кое чего приличного от нейросети добиваться.

Уже доступна работа с разрешением 1024 пикселя на современной видюхе (12 гиг памяти), а не обычные 512 пикселей для таких проектов. Плюс подключены в проге два апскейла - GFPGAN, который мы уже рассматривали, и CodeFormer - тот что у меня в примерах ниже.

Ключи поиска особо пока не настраивал, просто попробовал голубые глаза и зеленые глаза указать - да, глаза подкрасило так и эдак. Оригинальный плохой имидж прикладываю первым - я именно на его основе генерил два увеличенных варианта. Как бы меня прогресс порадовал, но конечно ждем больших разрешений моделей и большего кол-ва памяти более мощных GPU - тогда наверное и поры на коже станет прорисовывать. Я пробовал указать skin pores - но это пока на фактуру лица не повлияло.

Смотрите результаты, это всего за полчаса освоил в программе, сегодня только после ужина ее впервые установил. За этими технологиями будущее, так что стараюсь хоть как-то успевать приобщаться, и конечно графический интерфейс нам в помощь. Пишут, что из командной строки еще более могучее управление прогой Stable Diffusion - но потренироваться с GUI - уже неплохо.

Если немного поучиться и поосваивать - можно кое чего приличного от нейросети добиваться.

Уже доступна работа с разрешением 1024 пикселя на современной видюхе (12 гиг памяти), а не обычные 512 пикселей для таких проектов. Плюс подключены в проге два апскейла - GFPGAN, который мы уже рассматривали, и CodeFormer - тот что у меня в примерах ниже.

Ключи поиска особо пока не настраивал, просто попробовал голубые глаза и зеленые глаза указать - да, глаза подкрасило так и эдак. Оригинальный плохой имидж прикладываю первым - я именно на его основе генерил два увеличенных варианта. Как бы меня прогресс порадовал, но конечно ждем больших разрешений моделей и большего кол-ва памяти более мощных GPU - тогда наверное и поры на коже станет прорисовывать. Я пробовал указать skin pores - но это пока на фактуру лица не повлияло.

Смотрите результаты, это всего за полчаса освоил в программе, сегодня только после ужина ее впервые установил. За этими технологиями будущее, так что стараюсь хоть как-то успевать приобщаться, и конечно графический интерфейс нам в помощь. Пишут, что из командной строки еще более могучее управление прогой Stable Diffusion - но потренироваться с GUI - уже неплохо.

Вложения

- Сообщения

- 186

- Реакции

- 38

...Долго мне будут сниться во снеПопробовал проект с графическим интерфейсом NMKD Stable Diffusion GUI

Если немного поучиться и поосваивать - можно кое чего приличного от нейросети добиваться.

Уже доступна работа с разрешением 1024 пикселя на современной видюхе (12 гиг памяти), а не обычные 512 пикселей для таких проектов. Плюс подключены в проге два апскейла - GFPGAN, который мы уже рассматривали, и CodeFormer - тот что у меня в примерах ниже.

Ключи поиска особо пока не настраивал, просто попробовал голубые глаза и зеленые глаза указать - да, глаза подкрасило так и эдак. Оригинальный плохой имидж прикладываю первым - я именно на его основе генерил два увеличенных варианта. Как бы меня прогресс порадовал, но конечно ждем больших разрешений моделей и большего кол-ва памяти более мощных GPU - тогда наверное и поры на коже станет прорисовывать. Я пробовал указать skin pores - но это пока на фактуру лица не повлияло.

Смотрите результаты, это всего за полчаса освоил в программе, сегодня только после ужина ее впервые установил. За этими технологиями будущее, так что стараюсь хоть как-то успевать приобщаться, и конечно графический интерфейс нам в помощь. Пишут, что из командной строки еще более могучее управление прогой Stable Diffusion - но потренироваться с GUI - уже неплохо.

Ее голубые глаза на сосне...

Это же тихий ужас, с оригиналом ничего общего, практически...

Вложения

Как впрочем и до/после обычного макияжа...с оригиналом ничего общего

mihas

15 лет на форуме

- Сообщения

- 4 860

- Реакции

- 2 898

Кто-то лучше справится с десятикратным увеличением? Я показал, что картинка сделана не из оригинала, а из спичечного коробка!-) Из оригинала куда как круче и апскейлить не надо....Долго мне будут сниться во сне

Ее голубые глаза на сосне...

с оригиналом ничего общего, практически...

mihas

15 лет на форуме

- Сообщения

- 4 860

- Реакции

- 2 898

Ну я даже не тренировал модель по фоткам Маккензи Дэвис, чтобы отрисовать все вообще реалистично, это чуть большего времени требует - создание такой модели. Было бы желание.Как впрочем и до/после обычного макияжа

А есть альтенативы?Известная проблема нейросетевого увеличения

carry

20 лет на форуме

- Сообщения

- 2 722

- Реакции

- 1 035

Не использовать оригиналы низкого качества?)А есть альтенативы?

mihas

15 лет на форуме

- Сообщения

- 4 860

- Реакции

- 2 898

Я бы сказал немного иначе. Если реально потренировать модель недельку ну хоть на пушистых котиках, штук 300 хватит, то нейросеть нарисует пушистого котика круче оригинала. А мы пока приводим примеры фактически без тренировки, что-то нам дают производители какой-то набор сборный всего на свете, не индивидуализированный под задачу, конечно не идеально. Но важно понимать перспективу, что тут возможно очень серьезное обучение. Уже вон были кадры, когда персонаж в телевизоре проносит руку сквозь микрофон, если бы ни эта погрешность нейросети - никто бы и не узнал, что в кадре не человек, а модель нейросети. Натренированная модель, не людей вообще, а более конкретизированная.Известная проблема нейросетевого увеличения - теперь это будет похоже на нечто среднее по больнице, но не на оригинал

Последнее редактирование:

- Сообщения

- 624

- Реакции

- 144

А вот это не пробовали? Я для себя улучшал картинки из сети, а-ля 1920*1080, до печатного размера в 50*70 и 300dpi.

Ходить через ВПН.

Ссылка на летсэнханс.ио. Ссылка блокируется.

Ходить через ВПН.

Ссылка на летсэнханс.ио. Ссылка блокируется.

carry

20 лет на форуме

- Сообщения

- 2 722

- Реакции

- 1 035

Ходили-ходили. Все нормально, пока картинка чего-то широко распространенного. Как только эксклюзива - оно дает такое мутное пятно, как и Фотошоп. Из ничива нечива не вытащишьА вот это не пробовали? Я для себя улучшал картинки из сети, а-ля 1920*1080, до печатного размера в 50*70 и 300dpi.

Ходить через ВПН.

Ссылка на летсэнханс.ио. Ссылка блокируется.

Сдаётся мне, пройдет еще несколько лет и в интернете темы "как нейросетями улучшить фотографию" сменятся темами "где найти фотографию такого-то объекта не тронутую нейросетями" или "как определить, что фотография действительно не тронута нейросетями".

Потому что:

Потому что:

А вот нарисовать красиво выдуманное в это самое "ничево" за милую душу, а потом гадай, так оно было или нарисовали.Из ничива нечива не вытащишь

Поделиться:

![7-Mackenzie-Davis[1].jpg](/data/attachments/146/146848-2cb8987bdf4937d6065055150e056a18.jpg?hash=LLiYe99JN9)